Confluent, pioniere nel data streaming, annuncia significativi miglioramenti di Tableflow, la soluzione più semplice per accedere ai dati operativi da data lake e data warehouse. Con Tableflow, tutti i dati in streaming su Confluent Cloud possono essere accessibili nei formati di tabelle aperte più diffusi, aprendo infinite possibilità per le advanced analytics, intelligenza artificiale in tempo reale e applicazioni di nuova generazione. Il supporto per Apache Iceberg è ora disponibile (GA), e, grazie alla partnership con Databricks, è ora disponibile in early access per Delta Lake. Inoltre, Tableflow offre ora una maggiore flessibilità di archiviazione dei dati e integrazioni senza soluzione di continuità con i principali catalog provider, tra cui AWS Glue Data Catalog e il servizio gestito di Snowflake per Apache Polaris, Snowflake Open Catalog.

“In Confluent ci occupiamo di far funzionare al meglio i dati per i nostri clienti, sempre e in qualsiasi formato necessario”, ha dichiarato Shaun Clowes, Chief Product Officer di Confluent. “Con Tableflow portiamo la nostra esperienza nel collegare i dati operativi al mondo analitico. Ora, data scientist e data engineer possono accedere a un’unica fonte di verità in tempo reale in tutta l’impresa, rendendo possibile costruire e scalare la nuova generazione di applicazioni guidate dall’AI”.

Il fallimento dei progetti di AI: dati scollegati

“Entro il 2027, dopo vari insuccessi nei progetti di AI, il 70% dei team IT tornerà alle basi, concentrandosi su piattaforme di infrastruttura dati AI-ready”, si legge nel report IDC FutureScape: Worldwide Digital Infrastructure 2025 Predictions. Nel report si aggiunge che “molte organizzazioni IT si affidano a numerosi silos di dati e a una dozzina o più di copie diverse di dati. Questi silos e archivi di dati ridondanti possono essere un grande ostacolo per un efficace sviluppo di modelli di AI”.

I progetti di AI falliscono perché i vecchi metodi non riescono a tenere il passo con le nuove aspettative dei consumatori. Queste applicazioni devono conoscere lo stato attuale di un’azienda e dei suoi clienti e agire automaticamente. Ad esempio, un agente AI per la gestione dell’inventario dovrebbe essere in grado di identificare se un articolo è di tendenza, notificare immediatamente ai produttori l’aumento della domanda e fornire stime di consegna precise ai clienti. Questo tipo di efficienza hands-free non è possibile se i dati aziendali non sono trasmessi in tempo reale ai sistemi di analytics e di AI. I vecchi metodi di elaborazione batch portano a risultati inaccurati e copiare manualmente i dati è instabile, non scalabile e accentua il problema dei silos.

Colmare il divario dei dati per un’AI enterprise-ready con gli ultimi aggiornamenti di Tableflow

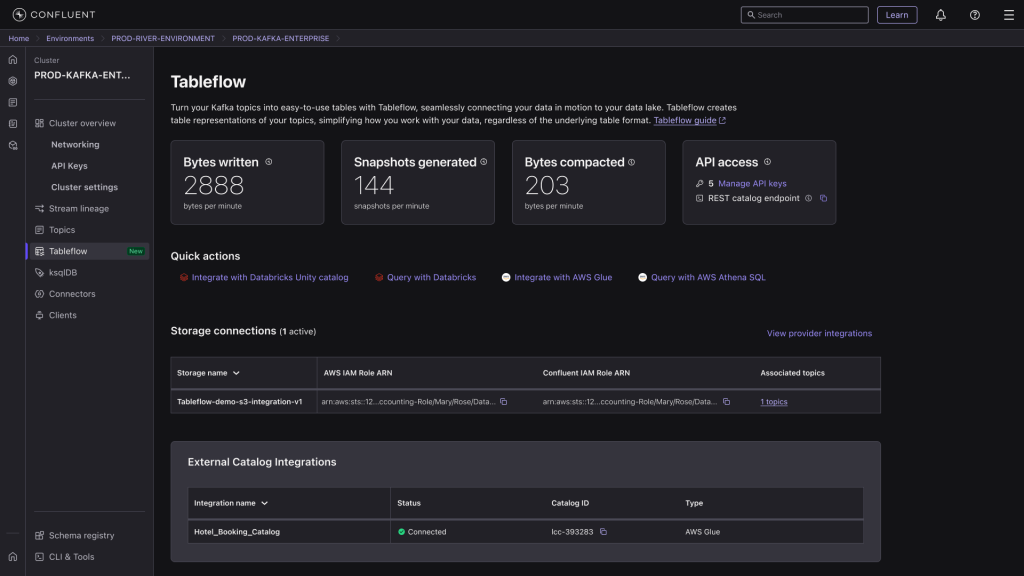

Tableflow semplifica l’integrazione tra dati operativi e sistemi analitici, aggiornando continuamente le tabelle utilizzate per analytics ed AI con gli stessi dati delle applicazioni aziendali collegate a Confluent Cloud. All’interno di Confluent, l’elaborazione e la governance avvengono nel momento stesso in cui i dati vengono generati, spostando questi task a monte per garantire che solo dati di alta qualità e coerenti alimentino data lake e data warehouse. Questa è una svolta per l’AI.

Confluent annuncia aggiornamenti significativi a Tableflow, tra cui:

- Il supporto per Apache Iceberg, pronto per carichi di lavoro di produzione. I team possono rappresentare istantaneamente i topic di Apache Kafka come tabelle Iceberg per alimentare qualsiasi data warehouse, data lake o motore analitico per casi d’uso real time o batch. I task di manutenzione delle tabelle, costosi e soggetti a errori, come la compattazione, sono gestiti automaticamente da Tableflow, liberando tempo prezioso ai data engineer. Fornisce anche un’unica fonte di verità per una delle opzioni di archiviazione open-format più ampiamente adottata, consentendo a data scientist e data engineer di scalare l’innovazione dell’AI e le applicazioni di nuova generazione.

- Il programma early access per Delta Lake è ora disponibile. Questo livello di archiviazione open-format, promosso da Databricks, elabora più di 10 exabyte di dati al giorno ed è utilizzato insieme a molti motori e strumenti di AI popolari. Con questa integrazione, i clienti avranno una visione coerente dei dati in real time tra applicazioni operative e analitiche, consentendo decisioni più rapide e intelligenti basate sull’AI.

- Flessibilità maggiore attraverso la modalità BYOS (Bring Your Own Storage). Le tabelle Iceberg o Delta aggiornate possono essere archiviate una sola volta e riutilizzate molte volte con la libertà di scegliere un bucket di archiviazione. I clienti hanno ora il pieno controllo sull’archiviazione e la compliance, soddisfacendo così le loro esigenze uniche di proprietà dei dati.

- Miglioramento dell’accessibilità e della governance dei dati con i partner. Le integrazioni dirette con Amazon SageMaker Lakehouse via AWS Glue Data Catalog (GA) e Snowflake Open Catalog (GA) abilitano la gestione senza soluzione di continuità dei cataloghi per le tabelle Iceberg di Tableflow. Semplificano anche l’accesso per motori analitici come Amazon Athena, AWS EMR e Amazon RedShift, e soluzioni leader di data lake e data warehouse tra cui Snowflake, Dremio, Imply, Onehouse e Starburst. Inoltre, Confluent ha rafforzato l’adozione aziendale di Tableflow con il supporto di System Integrators globali e regionali, tra cui GoodLabs Studio, Onibex, Psyncopate e Tata Consultancy Services (TCS).

Dichiarazioni

“Le aziende di trasporto ci apprezzano perché rendiamo molto semplici le vendite, le operations e le spedizioni, ma ciò è possibile solo con l’analisi dei dati in tempo reale”, ha affermato Brady Perry, Co-founder di Busie. “Tableflow offre un promettente percorso per il nostro motore di analytics per consumare senza soluzione di continuità i dati operativi in Kafka come tabelle Apache Iceberg, eliminando la necessità di pre-elaborazioni aggiuntive. Integrando Tableflow con Snowflake, possiamo evitare l’invio di dati grezzi e non puliti, riducendo complessità e costi di archiviazione. Questo approccio semplifica i flussi di lavoro e accelera l’acquisizione di informazioni, garantendo un’architettura dati più efficiente e conveniente”.