Il successo dell’Intelligenza Artificiale e dei LLM è innegabile. Sempre più aziende ne fanno richiesta per ottimizzare i processi. Snowflake, la Data Cloud company, risponde a queste esigenze e annuncia Snowflake Arctic, un large language model (LLM) all’avanguardia, progettato per essere il più aperto del mercato. Grazie all’esclusiva architettura Mixture-of-Experts (MoE), Arctic offre intelligenza ed efficienza senza precedenti su scala. Ottimizzato per i workload complessi, il modello ha superato diversi benchmark di settore per quanto riguarda la generazione di codice SQL, l’esecuzione di istruzioni e altro ancora e va ad affiancare la famiglia di modelli Snowflake Arctic che comprende anche i migliori modelli pratici di text-embedding per i casi d’uso di retrieval.

Snowflake sta rilasciando i carichi di Arctic sotto licenza Apache 2.0 e i dettagli della ricerca che ha portato al suo addestramento, stabilendo un nuovo standard di apertura per la tecnologia AI enterprise. Snowflake Arctic LLM fa parte della famiglia Snowflake Arctic, una famiglia di modelli costruiti da Snowflake che comprende anche i migliori modelli pratici di text-embedding per i casi d’uso di retrieval.

“Si tratta di un momento epocale per Snowflake in termini di innovazione AI”, dichiara Sridhar Ramaswamy, CEO di Snowflake. “Fornendo la migliore intelligenza ed efficienza del settore in modo veramente aperto alla comunità AI, stiamo ridefinendo i limiti di ciò che l’intelligenza artificiale open source può fare”.

Arctic apre la strada a una collaborazione veramente aperta e ampiamente disponibile

Secondo un recente report di Forrester, circa il 46% dei responsabili delle decisioni in materia di AI a livello aziendale ha dichiarato di sfruttare gli LLM open source esistenti per adottare l’AI generativa come parte della strategia della propria organizzazione. Snowflake consente a tutti gli utenti di sfruttare i propri dati con LLM aperti e innovativi, offrendo loro flessibilità e possibilità di scelta dei modelli con cui lavorare.

Ora, con il lancio di Arctic, Snowflake offre un modello potente e veramente aperto, con una licenza Apache 2.0 che consente l’uso personale, di ricerca e commerciale senza restrizioni. Facendo un ulteriore passo avanti, Snowflake fornisce anche modelli di codice, oltre a opzioni flessibili di inferenza e formazione, in modo che gli utenti possano iniziare rapidamente a distribuire e personalizzare Arctic utilizzando i loro framework preferiti. Questi includono NVIDIA NIM con NVIDIA TensorRT-LLM, vLLM e Hugging Face. Per l’utilizzo immediato, Arctic è disponibile per l’inferenza serverless in Snowflake Cortex, il servizio completamente gestito di Snowflake che offre soluzioni di machine learning e AI nel Data Cloud. Sarà anche disponibile su Amazon Web Services (AWS), insieme ad altri modelli e cataloghi, tra cui Hugging Face, Lamini, Microsoft Azure, NVIDIA API catalog, Perplexity, Together AI ed altri.

Arctic offre intelligenza di massimo livello con la migliore efficienza delle risorse

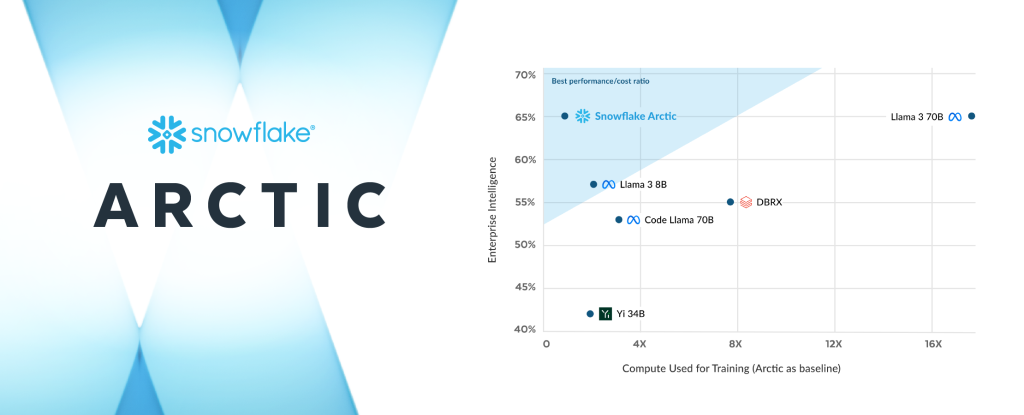

Il team di ricerca sull’AI di Snowflake, composto da ricercatori e ingegneri di sistema tra i migliori del settore, ha impiegato meno di tre mesi e ha speso circa un ottavo del costo di formazione di modelli simili per la creazione di Arctic. Addestrato utilizzano istanze P5 di Amazon Elastic Compute Cloud (Amazon ED2) Snowflake sta diventando il punto di riferimento per quanto riguarda la velocità di addestramento di modelli aperti enterprise allo stato dell’arte, consentendo, in ultima analisi, agli utenti di creare modelli personalizzati ed efficienti in termini di costi su scala.

Nell’ambito di questo sforzo strategico, il design differenziato del MoE di Arctic migliora sia i sistemi di addestramento che le prestazioni del modello, con una composizione dei dati meticolosamente progettata e focalizzata sulle esigenze aziendali. Arctic offre anche risultati di qualità, attivando 17 dei 480 miliardi di parametri alla volta per ottenere un’efficienza di token senza precedenti. Per l’appunto, Arctic attiva circa il 50% di parametri in meno rispetto a DBRX e il 75% in meno rispetto a Llama 3 70B durante l’inferenza o l’addestramento. Inoltre, supera i principali modelli aperti, tra cui DBRX, Mixtral-8x7B e altri ancora, nella codifica (HumanEval+, MBPP+) e nella generazione di SQL (Spider), fornendo al contempo ottime prestazioni nella comprensione del linguaggio generale (MMLU).

Snowflake continua ad accelerare l’innovazione AI per tutti gli utenti

Snowflake continua a fornire alle aziende la base di dati e i building block avanzati di cui hanno bisogno per creare potenti app di intelligenza artificiale e machine learning con i loro dati. Accedendo a Snowflake Cortex, Arctic accelererà la capacità dei clienti di creare app AI su scala, all’interno del perimetro di sicurezza e governance del Data Cloud.

Oltre ad Arctic LLM, la famiglia di modelli Snowflake Arctic comprende anche Arctic embed, recentemente annunciato, una famiglia di modelli di text embedding all’avanguardia, disponibili per la comunità open source con licenza Apache 2.0. La famiglia di cinque modelli è disponibile su Hugging Face per l’uso immediato e sarà presto disponibile come parte della funzione Snowflake Cortex embed (in private preview). Questi modelli di embedding sono ottimizzati per fornire prestazioni di retrieval a circa un terzo delle dimensioni di modelli analoghi, offrendo una soluzione potente ed economica quando si combinano insiemi di dati proprietari con LLM come parte di un servizio di Retrieval Augmented Generation o di ricerca semantica.

Snowflake dà inoltre accesso ai più recenti e potenti LLM del Data Cloud, comprese le recenti aggiunte dei modelli Reka e Mistral AI. Inoltre, Snowflake ha recentemente annunciato una partnership ampliata con NVIDIA che prevede l’integrazione della piattaforma accelerata full-stack di NVIDIA con il Data Cloud di Snowflake per offrire una combinazione sicura di infrastrutture e capacità di calcolo volta a sbloccare la produttività dell’AI. Snowflake Ventures ha anche recentemente annunciato investimenti in Landing AI, Mistral AI, Reka e altri ne verranno, per proseguire l’impegno di Snowflake nell’aiutare i clienti a creare valore dai loro dati aziendali con LLM e AI.

Alcuni commenti degli esperti di AI

“Snowflake Arctic è in grado di produrre risultati significativi che estendono la nostra partnership strategica, favorendo l’accesso all’intelligenza artificiale, la democratizzazione e l’innovazione per tutti”, dichiara Yoav Shoham, co-fondatore e co-CEO di AI21 Labs. “Siamo entusiasti di vedere Snowflake aiutare le imprese a sfruttare la potenza dei modelli open source, come abbiamo fatto con il nostro recente rilascio di Jamba, il primo modello Transformer-SSM basato su Mamba di livello produttivo. Il continuo investimento di Snowflake nell’AI è un fattore importante nella nostra scelta di costruire su Data Cloud, e non vediamo l’ora di continuare a creare maggior valore per i nostri clienti comuni”.

“Snowflake e AWS sono allineati nella convinzione che l’IA generativa trasformerà praticamente tutte le esperienze dei clienti che conosciamo”, dichiara David Brown, Vice President Compute and Networking di AWS. “Con AWS, Snowflake ha potuto personalizzare la propria infrastruttura per accelerare il time-to-market della formazione di Snowflake Arctic. Utilizzando le istanze Amazon EC2 P5 con l’efficiente sistema di formazione di Snowflake e la co-progettazione dell’architettura del modello, Snowflake è stata in grado di sviluppare e fornire rapidamente ai clienti un nuovo modello di livello aziendale. E con i piani per rendere Snowflake Arctic disponibile su AWS, i clienti avranno una scelta più ampia per sfruttare la potente tecnologia AI per accelerare la loro trasformazione”.

“La visione di Lamini è quella di democratizzare l’intelligenza artificiale, consentendo a tutti di costruire la propria super intelligenza. Crediamo che il futuro dell’AI aziendale si basi su potenti modelli aperti e su una collaborazione aperta”, dichiara Sharon Zhou, cofondatore e CEO di Lamini. “Snowflake Arctic è importante per sostenere questo futuro dell’AI. Siamo entusiasti di mettere a punto e personalizzare Arctic per ottenere LLM altamente precisi, ottimizzando il controllo, la sicurezza e la resilienza in un ecosistema AI dinamico”.