L’Intelligenza Artificiale sta conoscendo un enorme successo, con benefici innegabili per le aziende. Tuttavia, stanno emergendo dei limiti che le aziende non possono ignorare. È qui che entra in gioco l’observability.

In questo articolo, Francesco Battaglieri, Senior Sales Engineer per AI e Machine Learning presso Snowflake Italy, ci spiega cos’è l’observability e come, in ambito AI, stia diventando una necessità impellente.

Buona lettura!

ROI dell’AI non soddisfacente? L’observability potrebbe essere l’anello mancante

Dai chatbot, ai copilot per il coding, fino agli AI agent, le applicazioni basate sull’intelligenza artificiale stanno guadagnando un crescente consenso nel panorama aziendale. Tuttavia, insieme alla loro diffusione, emergono in modo sempre più evidente e critico anche i loro limiti intrinseci. Il rischio di ottenere risposte parziali, inappropriate o estremamente imprecise (note come “allucinazioni”), vulnerabilità nella sicurezza e output generici e insoddisfacenti rappresenta un ostacolo significativo all’adozione dell’AI in azienda.

Come le piattaforme e le applicazioni cloud-based hanno dato vita a nuovi strumenti di analisi, debugging e monitoraggio, anche lo sviluppo dell’AI richiede una suite dedicata di soluzioni per l’observability. Le applicazioni basate sull’intelligenza artificiale stanno acquisendo un’importanza tale da non poter più essere considerate semplici esperimenti, affascinanti ma non necessariamente affidabili: devono essere gestite con lo stesso rigore di qualsiasi altra applicazione critica per il business. In altre parole, l’AI richiede “observability”.

Che cos’è l’AI observability?

Il concetto di “observability” si riferisce all’insieme di tecnologie e procedure aziendali utilizzate per comprendere il funzionamento complessivo di un sistema, di una piattaforma o di un’applicazione. Nel contesto specifico delle applicazioni basate sull’intelligenza artificiale, l’observability implica una comprensione approfondita di tutti gli aspetti del sistema, dall’input all’output. Consente alle aziende di valutare e monitorare la qualità dei dati in ingresso, dei risultati prodotti e degli stati intermedi delle applicazioni basate su LLM, oltre a individuare e diagnosticare allucinazioni, bias e tossicità, nonché problematiche legate a prestazioni e costi.

L’observability in ambito AI sta diventando una necessità impellente proprio nel momento in cui questa tecnologia sta assumendo un ruolo cruciale, poiché i suoi limiti iniziano a emergere – limiti che per le aziende non sono accettabili.

Infatti, non è un caso che nei corsi di informatica avanzati si tenda a insegnare agli studenti di considerare le risposte dei LLM come potenziali allucinazioni, fino a prova contraria. La ragione risiede nel fatto che i LLM sono addestrati per generalizzare a partire da grandi quantità di testo, generando contenuti originali che riflettono i pattern presenti nei dati di training. Questi modelli non sono concepiti per memorizzare informazioni fattuali.

Quando i LLM vengono utilizzati in sostituzione dei motori di ricerca, gli utenti si approcciano ad essi con l’aspettativa di ottenere risultati non solo utili, ma anche precisi. Se l’intelligenza artificiale non riesce a fornire informazioni accurate, la fiducia viene inevitabilmente compromessa. Recentemente, due avvocati sono stati sanzionati per aver presentato una memoria legale redatta dall’AI che citava casi giuridici inesistenti.

Allucinazioni, vulnerabilità nella sicurezza e output imprecisi minano la fiducia che le aziende devono riporre nelle applicazioni basate sull’intelligenza artificiale, ostacolandone l’adozione in produzione. Quando un LLM fornisce risposte inadeguate, viene compromessa anche la fiducia dei consumatori nell’azienda stessa, causando potenziali danni alla reputazione del brand.

Oltre il “sufficientemente buono”

In ambito aziendale, l’obiettivo è quello di poter valutare e testare agevolmente l’accuratezza di diversi modelli e applicazioni, abbandonando l’approccio del “mi sembra accettabile”. Dalla valutazione iniziale al monitoraggio continuo, l’observability sta diventando un aspetto sempre più cruciale per qualsiasi organizzazione che faccia affidamento su applicazioni basate sull’intelligenza artificiale.

L’observability dell’AI consente ai proprietari di applicazioni di intelligenza artificiale di monitorare, misurare e correggere le prestazioni, contribuendo a tre diversi aspetti fondamentali dell’utilizzo dell’AI in azienda:

- Valutazione e sperimentazione: data l’abbondanza di modelli e strumenti di intelligenza artificiale disponibili sul mercato, è fondamentale che le aziende possano identificare agevolmente le componenti più adatte alle loro specifiche esigenze. L’observability è cruciale per valutare i diversi LLM, le opzioni di configurazione, le librerie importate nel codice e altri elementi, consentendo agli utenti di ottimizzare le proprie scelte tecnologiche per ogni singolo progetto.

- Monitoraggio e ripetizione: una volta che un’applicazione AI è stata implementata ed è in uso, l’observability supporta il monitoraggio delle sue performance e la registrazione delle tracce di esecuzione. In caso di problemi, è indispensabile per diagnosticare l’origine del problema, apportare le necessarie correzioni e validare la soluzione adottata, in un processo iterativo di miglioramento continuo familiare a chiunque abbia esperienza con il software cloud.

- Monitoraggio di costi e latenza: i leader tecnologici stanno acquisendo sempre più esperienza nell’ambito delle loro iniziative di AI. L’era degli investimenti incontrollati in questo campo volge al termine. Oggi l’attenzione si concentra sull’ottenimento di un ritorno sull’investimento (ROI) tangibile e sull’identificazione dei casi d’uso che generano risultati in termini di business. A questo proposito, le due variabili essenziali da misurare sono il costo di un’applicazione e il tempo necessario per fornire le risposte (la cosiddetta latenza). L’utilizzo di più GPU e server può ridurre la latenza, ma incrementa i costi. Trovare il giusto equilibrio per la propria applicazione richiede la capacità di misurare accuratamente entrambe le variabili. L’observability offre alle aziende un quadro più chiaro di questi due aspetti, consentendo loro di massimizzare i risultati e minimizzare le spese.

Aziende: cosa chiedere e aspettarsi dall’intelligenza artificiale?

Per le aziende che implementano applicazioni AI in produzione, “sufficientemente buono” non può più bastare. Affinché l’AI diventi una componente affidabile dell’infrastruttura aziendale, le risposte delle applicazioni LLM devono rispettare la “regola delle 3H”, ovvero essere “honest”, “harmless” e “helpful” (oneste, innocue e utili).

Devono essere oneste, ovvero accurate nei fatti e prive di allucinazioni. Le imprese devono poterle utilizzare per compiti in cui la loro capacità di generalizzare è apprezzata, come nel caso di riassunti, inferenze e pianificazione. Un’intelligenza artificiale onesta implica anche che il sistema riconosca e ammetta quando non è in grado di fornire una risposta accurata a una domanda. Ad esempio, se l’informazione richiesta non è disponibile, dovrebbe rispondere: “Non posso rispondere a questa domanda”, anziché generare un output casuale.

Per compiti che richiedono la memorizzazione dei fatti, è necessario integrare i LLM con informazioni e fonti dei dati aggiuntive per garantire l’accuratezza delle risposte fornite. In questo campo di ricerca attivo, noto come retrieval-augmented generation o RAG, il LLM consulta database di informazioni fattuali per rispondere alle specifiche domande degli utenti, corredando le risposte con i riferimenti alle fonti.

L’intelligenza artificiale deve essere innocua, il che significa che le risposte non devono esporre informazioni personali e devono essere resistenti agli attacchi “jailbreak”, progettati per eludere le misure di sicurezza implementate dai loro creatori. Queste misure di sicurezza sono essenziali per garantire che le risposte generate non contengano bias, stereotipi offensivi o contenuti potenzialmente dannosi.

Infine, l’intelligenza artificiale deve essere utile, fornendo risposte pertinenti e coerenti alle richieste degli utenti e risultati utili.

I tre aspetti del RAG

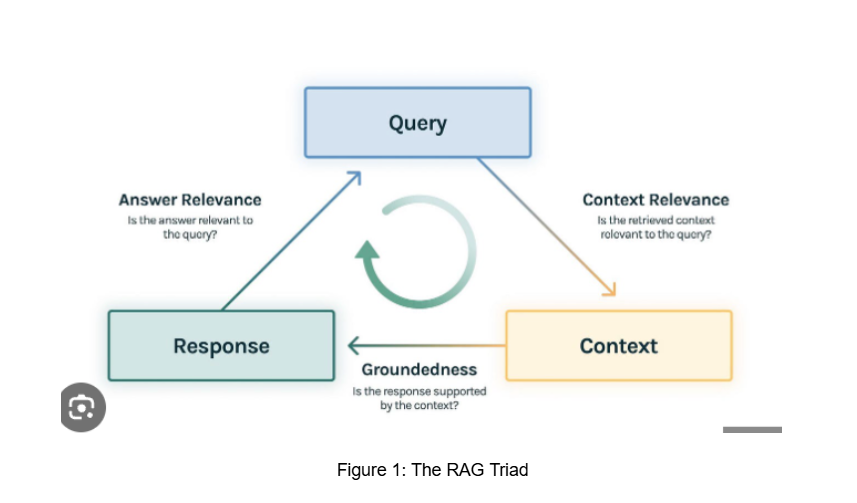

Per poter valutare l’onestà e utilità delle applicazioni RAG, si utilizzano tre metriche fondamentali che misurano la qualità delle fasi tipiche di queste applicazioni: rilevanza del contesto, fondatezza e pertinenza della risposta – volte a misurare la qualità delle tre fasi tipiche di queste tipologie di applicazioni.

- La rilevanza del contesto misura quanto ogni elemento recuperato dalla knowledge base sia pertinente alla domanda posta.

- La fondatezza misura quanto la risposta finale sia fondata sui frammenti di contesto recuperati o supportata da essi.

- La pertinenza della risposta misura quanto la risposta fornita sia pertinente rispetto alla domanda.

Scomponendo un sistema RAG nei suoi vari elementi (query, contesto e risposta), questo framework di valutazione è in grado di individuare i punti di errore e di fornire una comprensione più chiara dei punti in cui è necessario apportare miglioramenti al sistema RAG, in modo da guidarne un’ottimizzazione mirata.

La protezione contro potenziali danni comporta l’allineamento dei modelli (ad esempio, Llama Guard) e l’implementazione di guardrail nelle applicazioni per gestire aspetti come tossicità, stereotipi, attacchi malevoli e altre minacce.

Conclusione

Sono stati compiuti notevoli progressi verso il raggiungimento di tutti e tre questi requisiti. Grazie all’AI observability, è possibile prevenire le allucinazioni, identificare le risposte non pertinenti e incomplete e le vulnerabilità nella sicurezza. L’aumento dei flussi di lavoro degli agenti pone ulteriori sfide: occorre verificare che gli strumenti appropriati siano stati addestrati con i parametri corretti e nella giusta sequenza, che le tracce di esecuzione dei sistemi distribuiti multi-agente siano adeguatamente registrate e monitorate, e che il sistema end-to-end si comporti come previsto. Ciò sottolinea ulteriormente l’importanza dell’observability come tecnologia abilitante chiave, in grado di aiutare l’intelligenza artificiale a realizzare il suo pieno potenziale nel trasformare le aziende, ottimizzare i processi, ridurre i costi e sbloccare nuove opportunità di business.

di Francesco Battaglieri, Senior Sales Engineer, AI and Machine Learning, Snowflake Italy