Oggi l’Intelligenza Artificiale sta ridefinendo in modo sempre più incisivo e pervasivo le modalità con cui le aziende si relazionano e interagiscono con i propri clienti. Le capacità trasformative di questa tecnologia stanno generando un cambiamento radicale, per diversi casi d’uso: non solo nei modelli di servizio e nelle modalità di supporto, ma anche nella personalizzazione dell’esperienza utente e nell’ottimizzazione dei processi aziendali.

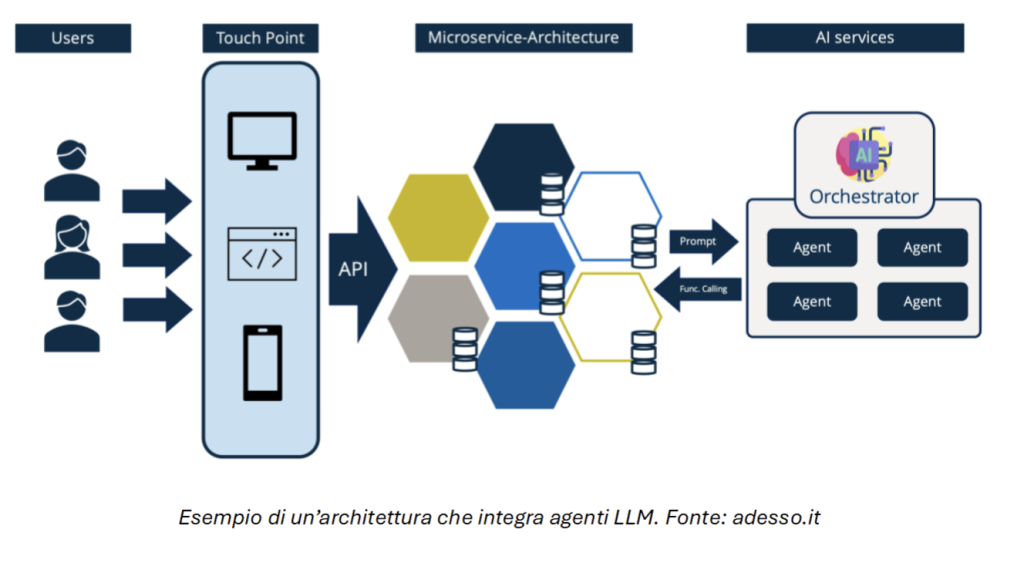

Nell’ambito di adesso.it, sono stati condotti diversi esperimenti con l’obiettivo di valutare l’impatto concreto dell’IA in scenari operativi reali. Tra le soluzioni esplorate, un focus particolare è stato posto sull’introduzione di Agenti LLM (Large Language Models), strumenti avanzati che si sono dimostrati particolarmente efficaci nell’esecuzione di compiti altamente specializzati e contestualizzati all’interno di domini specifici. Questi agenti sono progettati per integrarsi in ecosistemi software già esistenti, ampliando le capacità operative senza richiedere modifiche radicali all’architettura esistente.

L’approccio seguito prevede l’aggiunta di un layer di servizi AI all’interno dell’architettura “as-is”. Questo layer di intelligenza artificiale viene accuratamente orchestrato per garantire un’interazione fluida e sinergica con il software preesistente. Tali servizi AI fungono da intermediari intelligenti, consentendo agli utenti di dialogare in modo naturale con l’applicativo attraverso interfacce conversazionali avanzate.

Questo approccio consente di sfruttare le capacità di linguaggio naturale per comprendere le esigenze degli utenti, fornire risposte contestualizzate e migliorare significativamente l’efficienza operativa e la soddisfazione del cliente.

Rivoluzione nella UX/UI

L’impatto di questa tecnologia sull’esperienza utente non può essere sottovalutato. L’eliminazione delle interfacce tradizionali in favore di un’interazione conversazionale naturale abbatterà le barriere all’ingresso per molti utenti. Questa nuova modalità di interazione con gli applicativi li renderà fruibili anche da utenti che normalmente potrebbero trovare difficoltà nell’uso di interfacce web o con problemi di accessibilità.

Inoltre, la capacità dell’Agente di adattarsi al livello di conoscenza dell’utente permetterà un’esperienza personalizzata senza precedenti. Gli utenti più esperti potrebbero ricevere risposte concise e tecniche, mentre altri potrebbero beneficiare di spiegazioni più dettagliate e guidate. La stessa esperienza potrebbe adattarsi sulla base di come viene posta una determinata richiesta da parte degli utenti. Questo livello di flessibilità non solo potrebbe migliorare la soddisfazione dei clienti, ma potrebbe anche aumentare in modo significativo i tassi di conversione.

Un esperto sempre a disposizione

Uno dei vantaggi maggiori di un’architettura con AI Generativa integrata è che rende possibile, per ogni componente logica all’interno dell’applicativo, avere la sua controparte “intelligente”. Se opportunamente orchestrato, l’applicativo stesso potrebbe essere in grado di spiegare il suo funzionamento.

Ciò avrà implicazioni profonde per la formazione del personale e l’empowerment dei clienti. Le aziende potranno utilizzare questo strumento per standardizzare la conoscenza interna e garantire che tutti i clienti ricevano informazioni accurate e aggiornate, indipendentemente dal canale di comunicazione utilizzato. Inoltre, si ridurrà drasticamente l’effetto Lock-in sul know-how aziendale, inserendo la conoscenza dell’applicativo all’interno dell’applicativo stesso.

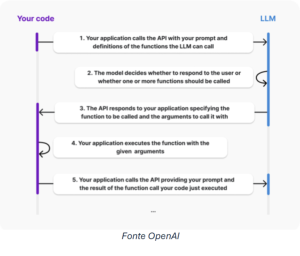

Sfide e insidie nell’implementare gli Agenti

Gli Agenti LLM sono sistemi che, una volta istanziati, possono avere a disposizione diversi Tool (funzioni che il modello può utilizzare per svolgere azioni specifiche o raccogliere informazioni che non rientrano nelle sue conoscenze statiche) con cui interagire. Il “Function Calling” è la capacità di connettere in modo affidabile gli Agenti ai Tool, permettendo l’interazione con API esterne. l’Agente riceve l’input dell’utente, lo elabora comprendendo l’intento e decide in autonomia quali Tool andare a chiamare. A questo punto inizia un “dialogo” con il Back-end, il quale esegue le operazioni necessarie in modo deterministico, affidandosi ai dati forniti dall’Agente.

Tuttavia, nonostante l’apparente semplicità, il sistema presenta ancora numerose sfide tecnologiche. In alcuni dei nostri test, dopo un periodo iniziale di corretto funzionamento, l’Agente ha iniziato a mostrare comportamenti imprevedibili, fornendo risposte incoerenti e fallendo nell’esecuzione dei compiti per cui era stato addestrato. La natura “black box” di molti sistemi di IA avanzati può rendere difficile diagnosticare e risolvere problemi quando si presentano, per riportare il software al comportamento deterministico che ci aspettiamo quando utilizziamo degli applicativi in azienda. Questa imprevedibilità solleva questioni critiche sull’affidabilità di tali sistemi in ambienti di produzione.

La sfida della documentazione e del supporto

Le tecnologie di IA stanno evolvendo a un ritmo vertiginoso e questo rapido sviluppo spesso si traduce in uno scarso know-how, lasciando gli sviluppatori a navigare in acque ancora inesplorate. Questo è un altro ostacolo significativo per l’implementazione: documentazione tecnica ancora da arricchire e una community a supporto viva ma non ancora sufficientemente ampia.

Questa mancanza di risorse costringe i team a procedere per tentativi ed errori, un approccio che, sebbene possa portare a scoperte innovative, potrebbe allungare significativamente i tempi di sviluppo e implementazione. Sebbene questo processo iterativo sia accettabile in un ambiente di ricerca o di prototipazione, può risultare problematico quando si lavora in un contesto aziendale con scadenze strette o budget limitati.

La necessità di un approccio cauto e supervisionato

È cruciale adottare un approccio cauto e altamente supervisionato nell’implementazione di tecnologie di IA avanzate in ambienti di produzione. È fondamentale riconoscere che, nonostante i rapidi progressi, questi sistemi sono ancora lontani dall’essere completamente autonomi e affidabili.

Un’implementazione responsabile richiede la messa in atto di robusti sistemi di monitoraggio e controllo tra cui:

· L’utilizzo di pratiche di sviluppo Agili: le pratiche Agili consentono cicli iterativi brevi e la possibilità di raccogliere feedback costanti da tutti gli stakeholder di progetto.

· Supervisione umana continua: formare e mantenere il personale qualificato per monitorare le interazioni dell’IA e intervenire quando necessario.

· Sistemi di fallback: implementare meccanismi che possano prendere il controllo in caso di malfunzionamento dell’IA, garantendo la continuità del servizio.

· Test rigorosi e continui: sottoporre regolarmente il sistema a batterie di test per identificare potenziali problemi prima che raggiungano gli utenti finali.

· Aggiornamenti graduali: invece di implementare cambiamenti radicali, optare per un approccio incrementale che permetta di valutare l’impatto di ogni modifica.

· Trasparenza con gli utenti: comunicare chiaramente agli utenti che stanno interagendo con un sistema di IA, con le sue potenzialità e limitazioni.

L’implementazione di uno o più Agenti LLM all’interno del proprio flusso di lavoro rappresenta un caso studio affascinante. Da un lato, promette di rivoluzionare l’esperienza utente, rendendo le interazioni più naturali, personalizzate ed efficaci. Dall’altro, mette in luce i rischi e le complessità associati all’adozione di tecnologie innovative e ancora in fase di maturazione.

Il successo nell’implementazione di tali sistemi richiede un delicato equilibrio tra il desiderio di innovazione e la necessità di affidabilità e stabilità. Le aziende che intendono adottare queste tecnologie devono essere preparate a investire non solo nello sviluppo iniziale, ma anche nel monitoraggio continuo, nell’ottimizzazione e nello studio di soluzioni alternative.

A cura di Federico Riboldi, Project Leader & AI Expert in adesso.it